Gradinet Descent with Momentum

Gradient Descent with Momentum은 추세/관성 (Momentum)을 GD에 반영하는 것이다.

Memory를 기반으로 Gradient를 갱신한다.

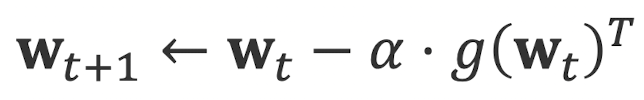

다음과 같이 일반적인 Gradient Descent 수식을 보면 g(wt)를 t가 늘어날 때마다 매번 새로 설정해야하는 것을 볼 수 있다.

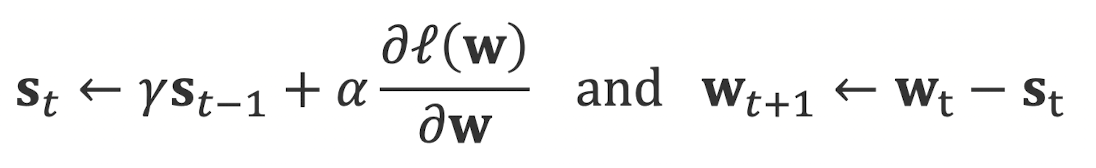

Gradient Descent with Momentum은 매 Iteration에서 정보를 기록하고, 다음 step의 gradient를 설정할 때 이전의 상황을 반영함으로써 Local minimum에 빠지는 것을 많이 완화해준다. 수식은 다음과 같다.

이 수식으로 볼 수 있듯, s(t)를 만들 때 s(t-1)을 반영하며, w(t+1)을 다룰 때 t에 대한 수식을 반영함을 알 수 있다.